LLMにおける幻覚(hallucination)の「効用」について(「IISIA技術ブログ」Vol. 15)

一頃までしばしば取り扱われていたものの、最近では人工知能科学者の間であまり語られなくなったテーマが一つある。それは大規模言語モデル(LLM)がどうしても発生させてしまう幻覚(hallucination)の「効用」についてである。

この幻覚(hallucination)については一般メディアでもしばしば取り上げられることがあるので、読者の多くがご存じかと思う。大規模言語モデル(LLM)はその入出力が対話形式だと、質問する側の私たちは人工知能(AI)が私たちの言っていることを本当に「理解」をし、その上で「回答」してくれているのだと思ってしまう。とりわけOpenAiが提供しているChatGPTは最終的な回答につき「丁寧な口ぶり」で答える様に訓練されているので、ついついそう思ってしまうわけである。しかしその実、大規模言語モデル(LLM)がやっているのは、1)ある既存のデータセットについて、2)そこにある文章に含まれる単語から生成したベクトルを計算する中で、3)次の単語がどうなるのかを確率的に推論しているだけに過ぎない、のである。ただし問題は「ある既存のデータセット」という部分なのであり、私たちが行う「質問」の続きに相当する部分の文章が確率論的に見てこの「ある既存のデータセット」になかった場合にどうするかということなのだ。大規模言語モデル(LLM)はこの時、とにかく何等かの他の文脈で使われている単語列がここでの「回答」として用いるにふさわしいかどうかを確率論的に計算する。そしてその結果、4)「正しい回答」ではないものの、ヒト同士の会話としては成り立つ様な、そんな文章を「回答」として出して来、そしてこれを私たちは信じてしまうというわけなのである。これがいわゆる幻覚(hallucination)という現象に他ならない。世の中に無限の数存在する全ての単語列を既存データとして取り入れ、学習させることは不可能だ。したがって大規模言語モデル(LLM)は原理的にこの幻覚(hallucination)からは逃れられないということになってくる。

大規模言語モデル(LLM)における幻覚(hallucination)については例えば[Ji et al. 24]による包括的な論文紹介がある。そこでは一般的な文脈から説き起こし、大規模言語モデル(LLP)における「幻覚(hallucination)」につき次のとおり述べられている。

In the general context outside of NLP, hallucination is a psychological term referring to a particular type of perception. Blom define hallucination as “a percept, experienced by a waking individual, in the absence of an appropriate stimulus from the extracorporeal world”. Simply put, a hallucination is an unreal perception that feels real. The undesired phenomenon of “NLG models generating unfaithful or nonsensical text” shares simliar characteristics with such psychological hallucinations – explaining the choice of terminology. Hallucinated text gives the impression of being fluent and natural despite being unfaithful and nonsensical. It appears to be grounded in the real context provided, although it is actually hard to specify or verify the existence of such contexts. Similar to psychological hallucination, which is hard to tell apart from other “real” perceptions, hallucinated text is also hard to capture at first glance.

Within the context of NLP, the above definition of hallucination, the generated content that is nonsensical or unfaithful to the proveded source content, is the most inclusive and standard.

ここで翻って考えると、例えば会議をしている時に突拍子もない発言をする出席者がいたりする。時にそうした人物の発言は議事進行を妨げ、まとまるものもまとまらなくなる原因になったりするわけであるが、しかし別の状況、とりわけ「議論が煮詰まっている時」にはそうした突拍子の無い発言が意外にも議論を推し進めることになったりもするのである。

大規模言語モデル(LLM)にも一部の論者の間でこれまで盛んにいわばそうした「名脇役」の様な機能を果たすことを期待し、研究がなされてきた経緯がある。その際、キーワードとされてきたのが例えば「創造的記述(creative writing)」である。例えばこの点を捉え、[Gómez-Rodríguez et al. 23]はfluency, coherence , originality, humorさらにstyleといった人的評価に際しての規準を当てはめた上で、商用利用可能な大規模言語モデル(LLM)による記述がヒトによるそれよりも成績が良かったと報告している。また[Franceschelli et al. 23]はさらに「創造的記述」に関し、アーガレット・ボーデン(Margaret Boden)が提唱する枠組みに則って、大規模言語モデル(LLM)による「創造的記述」について評価を試みている。こうした取り組みと並行して、[Chakrabarty et al. 24][Wan et al. 23]は大規模言語モデル(LLM)単独による記述ではなく、むしろ記述者としてのヒトとの協働によって「創造的記述」が可能であり、また有用なのではないかと論じる方向性での研究をしたものである。

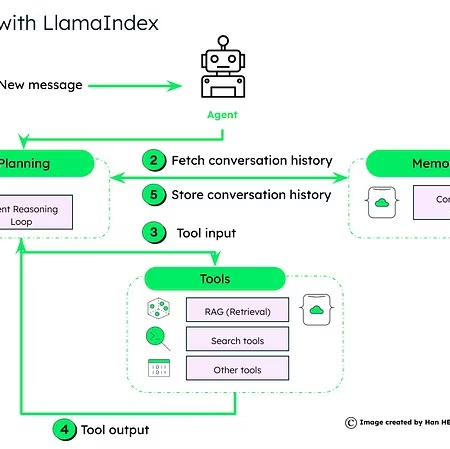

しかしこうした方向性、すなわち大規模言語モデル(LLM)によるテキスト生成が「創造的である」と述べる者は今やもはや少数派であり、むしろ一方ではRAG(retrieval augumented generation)、他方ではファインチューニング(fine tuning)といった手段でヒトによる質問が提示する単語ベクトルから確率的に推論した単語列を吐き出すに際し、元来学習しているデータを増やすか、あるいはそこでの推論の方向性を定める学習を特定の方向性に向け精緻にするといった努力を行う研究者が多勢である様に想われる。ただし、この研究の方向性は大いなる矛盾をはらんでいることに読者もお気づきなのではないだろうか。なぜならば上述のとおり、有史以来、ヒトが文字をもって記述してきた文章(単語列)は無限に近い量があり、かつ今後もまた膨大な量のテキストが生成されていくからだ。したがってそれらをすべてデータベース化することは出来ないし、ましてや事前学修させることも出来ないのだ。したがって幻覚(hallucination)はむしろ必然的なのであって、これとどの様に共存し、さらにはむしろこれを利活用するのかという方向へと議論が導かれるべきなのである。

筆者が今もっとも注力している研究分野は「生成AIと外交(Generative AI and Diplmoacy)」である。この分野においても、基本的に状況は同じである。そうした中で筆者としては、より精緻なテキスト生成を求めて生成AIを用いるというよりも、むしろその「幻覚(hallucination)」がある意味、突拍子の無いことを語るが故に、前例にとらわれすぎな外交当局者の思考をもみほぐしてくれる様な回答を戻すことを通じ、外交分野での未来に向けた戦略シナリオ作りのツールを大規模言語モデル(LLM)が作り出すことは出来ないかと思い、研究を進めている。我が国の政治、そして官僚の世界では大規模言語モデル(LLM)について一時期、鳴り物入りでその導入・活用が叫ばれたものの、実際には全く進められていないと聞く。なぜならばそこに「テキスト生成に際しての精緻さ」を求めるからなのではないかと推察できるからである。しかしこれを求めるのは原理的に大規模言語モデル(LLM)、もっといえば人工知能(AI)には現状のパターンマッチング演算を前提する以上、土台無理なのである。この方向での研究につき、まとまった言語データにつき許諾を得たので、今年(2024年)中にはとりまとめ、来年(2025年)、学会発表をしていければと考えている。正に「幻覚(hallucination)の効能」といったところであろうか。

2024年4月14日 東京・丸の内にて

株式会社原田武夫国際戦略情報研究所 代表取締役CEO/グローバルAIストラテジスト

原田 武夫記す

*この点も含め、来る4月20日午後に開催致します「IISIA17周年記念講演会」ではじっくりとお話をさせて頂きます。お申込み・詳細は是非こちらからどうぞ(下線部をクリック)。

【参考文献】

[Chakrabarty et al. 24] Chakrabarty, Tuhin, et al. “Creativity support in the age of large language models: An empirical study involving emerging writers.” arXiv preprint arXiv:2309.12570 (2023). [Franceschelli et al. 23] Franceschelli, Giorgio, and Mirco Musolesi. “On the creativity of large language models.” arXiv preprint arXiv:2304.00008 (2023). [Gómez-Rodríguez et al. 23] Gómez-Rodríguez, Carlos, and Paul Williams. “A confederacy of models: A comprehensive evaluation of LLMs on creative writing.” arXiv preprint arXiv:2310.08433 (2023). [Ji et al. 24] Ji, Ziwei, et al. “Survey of hallucination in natural language generation.” ACM Computing Surveys 55.12 (2023): 1-38. [Wan et al. 23] Wan, Qian, et al. “” It Felt Like Having a Second Mind”: Investigating Human-AI Co-creativity in Prewriting with Large Language Models.” arXiv preprint arXiv:2307.10811 (2023).