生成系AIはトピックモデルの座を完全に奪ったのか?(「IISIA技術ブログ」Vol. 9)

現在、引き続きテキスト生成系AIの我が国における社会実装、とりわけ外交実務における実装を念頭においた実験と論文執筆に取り組んでいる。現在、7合目を超えたあたりであるが来月(11月)一杯くらいまでは仕上げるまでにかかりそうである。それまでの間はこの論文作成にかかりっきりとなる。そうした中でふと気になったことを、やや自然言語処理(NLP)よりの話題ではあるが、ここで書いておきたいと思う。

それは自然言語処理(NLP)というとつい最近まで圧倒的な勢いを誇っていたトピックモデル(Topic Modelling)が全く意味を失ったのかというイシューである。「意味を失う」という時、ここでは一方において学問的(academic)に意味を失ったのかという論点であり、かつ他方では社会実装における有用性が無くなったのかという論点でもある。以下、順に卑見を述べたいと思う。

まずトピック・モデルについて簡単に説明する。[Blei et al., 03]は文書の確率的生成モデルとして潜在的ディクレリ配分法(Latent Dirichlet Allocation, LDA)を提案する。その際、文書中の単語の順序は無視し、Bag of Words(BoW)表現(単語と出現頻度のペアの集合)をモデル化する。BoW表現は単語が共起している現象に注目しており、文書集合として考えると統計的に共起しやすい単語の集合がいくつか存在する点に注目するものである。LDAはこの単語の共起性を統計モデルとして数理的に扱うために提案されたものであり、各文書には潜在トピックがあると仮定し、統計的に共起しやすい単語の集合が生成される要因を、この潜在トピックという観測出来ない確率変数で定式化する。以下にLDAのグラフィカルモデルを示す[Blei et al., 03]。単語wは観測される変数であり色付きの円の中で示され、トピックz 、トピック分布θ、ハイパーパラメーターα及びβはそれぞれ未知変数であるので白地の円の中で示されている。またMはM文書であることを示し、Nはそれぞれの文書にN単語含まれていることを示す。トピック分布θは文書ごとにあり、トピックzは単語ごとにあることが分かる。LDAではトピック分布θにディリクレ事前分布を仮定し、ベイズ推定を行う。

![2: The graphic model of LDA Blei et al. [2003]. The replicates are... | Download Scientific Diagram](https://www.researchgate.net/publication/266271406/figure/fig17/AS:650539742269443@1532112169746/The-graphic-model-of-LDA-Blei-et-al-2003-The-replicates-are-represented-as-the-two.png)

LDAを発展させたのが[Roberts et al., 14]が提案する構造的トピックモデル(Structural Topic Model, STM)である。これはLDAモデルに共変量(covariance)を入れるものであり、そこではLDAと異なり、文書にトピックを割り当てる分布、あるいは各トピックにおける単語の分布を、文書外の共変量に位置づける点に特徴がある。またSTMはトピック間において相関を想定した相関トピックモデル(corelated topic model)の一つであり、これにメタ情報であるtopical prevalance(あるトピックと関連するドキュメントの割合)とtopical content(あるトピックで利用される単語群)を組み込んだ手法である。Rパッケージの一つとしてオンライン上でダウンロードすることが可能でもある。

この様な発展形も頻用されるようになっているトピックモデルであるが、要するにそのメルクマールとなっているのが「ある文書には潜在的にトピックがある」という想定であり、かつその計算結果である。これについてWordCloudで表現をしたり、あるいはPCoA(Principal Coordinate Analysis, 主座標分析)やMDS(Multi-dimensional scaling, 多次元尺度豹)等によって可視化するというのが典型的なパターンである。

トピックモデルについて以上の様な極めて簡単な特徴描写を前提にしながら、テキスト生成系AIとの違いについて次に述べる。まず社会実装にあたってどういったタスクを想定するのかという論点がある。ここでは外交実務においてしばしば行われる「要約」業務について取り上げることにする。外交実務においてしばしば数十、数百ページといった長文の英文テキストを前提とした交渉が行われることがある。英語をネイティヴ・ランゲージとしない我が国外交においてこうした場合にしばしば必要となってくるのが「要約(summarization)」である。中央省庁の内部における議論ならば英文の文書そのものをもって協議をするといったこともあろうが、しかしその中であっても大臣以下の政務レヴェルに話をあげるとなると当然「長文の英文オリジナルテキストを要約し、日本語翻訳したもの」が必要となってくる。多くの場合、若手の末端担当職員が非常に手を焼いているのがこうした職務であると想定される。

ChatGPTといったテキスト生成系AIにこうした長文の英語テキストの要約(翻訳)を指示すると仮定しよう。本稿執筆段階で例えばChatGPTはOpenAIが直接提供しているサーヴィスを用いるにあたり、月額20米ドルでGPT4を用いることの出来るランク(ChatGPT plus)を提供している。このランクでは、従来インプットすることの出来なかった長文のテキストをAdvanced Data Analysisを利用登録することでインプットすることが可能である。ここまでの作業は特段問題なくこなすことが誰でも可能である。

しかし問題は実は「その次」から生じるのだ。まずインプット(アップロード)する文書がテキストファイル(txt)なら良いが、PDF文書(pdf)であった場合、図表なども多くの場合そこには含まれるため、ChatGPTではそこにあるテキストを抽出するのに手間がかかる。複数のやり方を提案してくるため、ChatGPTとの(時に長時間にわたる「対話(=プロンプトを複数入力する)」が必要になってくる。多くの場合、長文テキストはChatGPT上で複数に分割され、ようやく次の作業である「要約(summarization)」に持ち込まれることになる。

ところがこの次のステージでも一筋縄にいかないのが通例なのだ。要約の作成には、その代表的な文章をそのまま抜き出してくる(extractive)手法と文脈から意味を抜き出してくる(abstractive)手法の2つがある。ChatGPTは場合に応じて「要約」タスクをこなすため様々なアルゴリズムを利用とするため、このいずれを用いるのかは不確定である。無論、プロンプトで利用者の方がアルゴリズムを指定することも可能であるが、それでは最初から当該アルゴリズムを利用者自身がコーディングしてコーパスを入れれば良いのであり、ChatGPTの利便性が大きく減ってしまう。そのためいきおいプロンプトは「最善の方法で処理してください」といった入力となり、アルゴリズムの選択は事実上、ChatGPT側に任されることになる。しかも一度複数のテキストに分割しているため、それぞれについて要約が作成されるのであって、次にこれら複数の要約の「要約」を作成せよというプロンプトの入力の必要がある。さらにいえば原文テキストが英文であった時、今度はこれを「翻訳」するというタスクも課すことになる。結構、一苦労である(想定していた以上に手間暇がかかるというのが率直な印象である)。

現在執筆中の論文作成のため、実験を行っているが、成果物として出て来る「要約」を翻訳することなく、原文テキストにそもそも付随している「要約」とBERTScore[Zhang et al., 19]で比較しても、平均的に見るとスコアは良くて0.8、悪い時には0.5程度にまで落ちてしまうのが実態である。つまりこれらのスコアを1から引いた値に相当するのが「幻覚(hallucination)」ということになってくるわけであって、どうしても熟練した職員による目視でのチェックが必要になって来る。この時、「そうであれば最初から自分が要約する」とこれら熟練した職員らが言い出す可能性も、実務上は排除出来ないように思われる。実務上、「ほぼ完ぺき」かあるいは「ほとんど出来ていない」のであればチェックすることが楽であるが、「中途半端に出来ている」成果物をチェックするのは意外に手間暇がかかるからである。

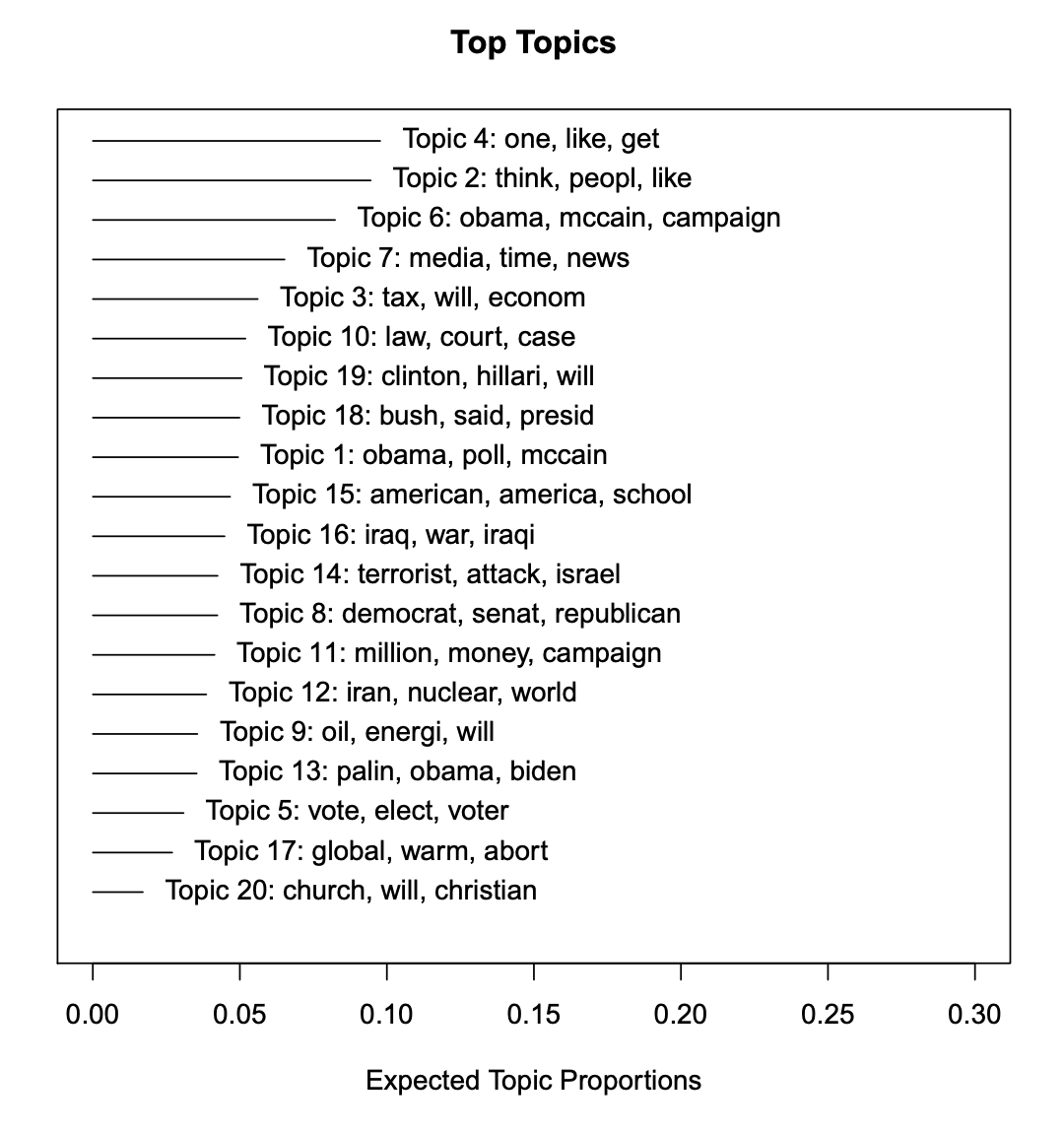

以上のテキスト系生成AIとの比較においてトピックモデルで出力されるのは、「潜在的トピック」に過ぎない。またLDAであれ、STMであれ、「適正な」前処理を施し、BoW表現にしてしまうため、基本的に成果物が表現するのは「単語ベース」での世界となる。これでは、「要約」作業を実務面でしばしば担当する若手の末端担当職員では何が何だかわからず、これだけで作業を進めよといっても困惑してしまうに違いない。STMによる潜在的トピック分析の例を以下に示す(上がSTM、下がLDA)。

端的に言って「要約」の作成というタスクに限ってみると、トピックモデルだけではなかなか厳しいということをお分かり頂けたのではないかと思う。若手の末端担当職員がこのトピックモデルによる計算結果だけから、目の前にある長文テキストの「要約」を作成せよというのはかなり難があると言わざるを得ない(ただしSTMの場合、複数の文書をインプットした上でトピックを時系列別に析出するとすれば、当該トピックがベースとした文書を特定もしてくれるので(入力文書の中から)、あるトピックについて何等かの新規文書を作成したいとした場合、より参考になる文書をまずは抽出・選定するという作業を行ってくれるという利用方法はある)。他方で、トピックモデルの利用にあたり各種前処理を最適化し、微細なチューニングすることでより明確かつイメージの湧きやすい単語量の潜在的トピックをリストアップ出来れば、熟練した担当職員によっての「要約」作業はややスピードアップする可能性はある(あらかじめ何のトピックにあたりをつけるとより的確な「要約」が出来そうだという意味において)。ただしそれはあくでも「それまである程度の実務をこなし、知見が頭脳に入っている」という意味での自然知能(natural intelligence)と、人工知能(aritificial intelligence)の協働を前提とするわけであるが。

以上の分析を踏まえて言うならば結論はただ一つ。生成系AIの登場・活用により、「要約」作成という我が国の行政実務に際してしばしば必要となる作業の効率性を上げるという文脈において、トピックモデルが持ち得る効能の意味が全くなくなったということは出来ない。結局は利用者がある作業の成果物についてどういったイメージを抱いているのか、何をゴールとしているのかによって、自らの能力を拡張する(augument)のために選択すべく、複数の手段が出来ているといったレヴェルのイシューなのだということを認識しておく必要がある。実際、要約文を大臣に説明するよりも、「要はこういったことを取り上げています」とトピック・モデルの計算結果をWordCloudや潜在的トピックのリストで示した方が「大臣」の頭に入りやすい例もあるであろう。その意味で生成系AI万能論は奉じるべきではなく、AI活用と比例して実はミドルマネジャー以上の熟練した労働者がチェッカーとして絶対的に必要になってくることを十分認識しつつ、結局は利用者が何を利用しようとしているのかによるのだ、ということをここでは読者と共に確認しておいたいと思う。

2023年10月29日

東京・丸の内にて

株式会社原田武夫国際戦略情報研究所 代表取締役CEO / グローバルAIストラテジスト

原田武夫 記す

(参考文献)

[Blei et al., 03] Blei, David M., Andrew Y. Ng, and Michael I. Jordan. “Latent dirichlet allocation.” Journal of machine Learning research 3.Jan (2003): 993-1022. [Roberts et al., 14] Roberts, Margaret E., et al. “Structural topic models for open‐ended survey responses.” American journal of political science 58.4 (2014): 1064-1082. [Zhang et al., 19] Zhang, Tianyi, et al. “Bertscore: Evaluating text generation with bert.” arXiv preprint arXiv:1904.09675 (2019).